"Tôi nghĩ một ví dụ điển hình là cách con người đối xử với động vật. Không phải là chúng ta ghét động vật. Tôi nghĩ con người yêu động vật và có nhiều tình cảm với chúng. Nhưng khi đến lúc phải xây dựng đường cao tốc giữa hai thành phố, chúng ta không xin phép động vật. Chúng ta chỉ làm vậy vì nó quan trọng đối với chúng ta. Tôi nghĩ đó chính là loại mối quan hệ sẽ tồn tại giữa chúng ta và các AGI (Artificial General Intelligence - trí tuệ tổng quát nhân tạo) - chúng sẽ thực sự tự chủ và hoạt động trên lợi ích của chúng", Ilya Sutskever nói.

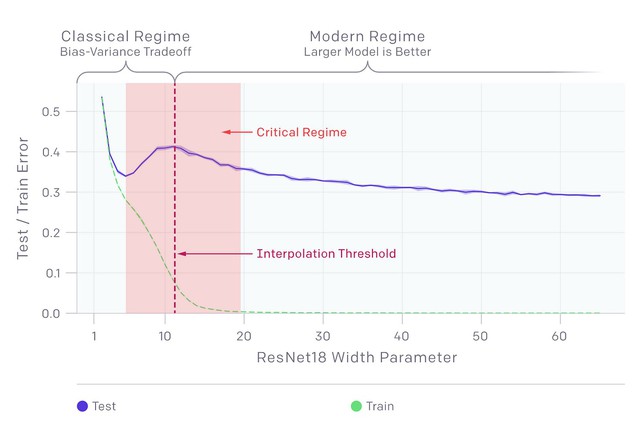

Là người có trình độ khoa học và tầm nhìn nhất OpenAI, Ilya Sutskever cùng đội Boaz Barak (nhà khoa học hàng đầu về khoa học máy tính và mật mã ở Đại học Harvard) đưa ra "Deep double-descent" phenomenon, nhận định rằng: Khi mô hình lớn lên, hiệu quả trước tiên sẽ giảm xuống rồi sau đó lại tốt hẳn lên. Đây là quan điểm khác hẳn với Yann Le Cun, người cho rằng các mô hình hiện tại đang phát triển ở OpenAI sẽ đến lúc bão hoà dữ liệu và dù có thêm nhiều dữ liệu cũng không tăng nhiều hiệu quả. Do đó mà muốn tiến lên mức mới, cần một mô hình mới đột phá. Sự nguy hiểm của "Deep double-descent" phenomenon là ở chỗ, không cần thiết mô hình đột phá cách mạng gì thêm, chỉ cần thu thập dữ liệu khổng lồ, tăng kích thước mô hình khổng lồ là AGI có thể sẽ tới. Chính vì thế, nó sẽ có thể sớm xảy ra khi việc thu thập dữ liệu, dữ liệu cá nhân hiện tại chẳng cần quy tắc quy chuẩn gì và đang được tiến hành với tốc độ tên lửa.

“Deep double-descent” - Khi các mô hình ngày càng lớn, hiệu quả sẽ có lúc giảm, gây cảm giác tới hạn, nhưng sau đó sẽ tăng trở lại

Ai có thể hiểu nhất và có thể nói ra những nguy hại trên một cách sát thực tế, những thứ đang diễn ra âm thầm trong các đại công ty AI?

Ilya Sutskever hiểu, nhưng dù sao vẫn không thể nói hết ra ngoài, vì ông ta là kiến trúc sư trưởng của OpenAI.

Vậy thì ai? Theo tôi, đó chính là Boaz Barak (GS Đại học Harvard) và Scott Aaronson (Giám đốc Trung tâm Nghiên cứu lượng tử của Đại học Texas ở Austin) - hai nhà khoa học nổi tiếng, có tầm nhìn và có thực tế làm việc trực tiếp gần gũi nhất với những gì thực sự đang diễn ra, với Ilya Sutskever.

Ilya Sutskever (đứng) và Sam Altman - những nhà lãnh đạo của công ty hàng đầu thế giới về AI hiện nay - OpenAI

Scott Aaronson nói: "Tôi có những cuộc gọi hằng tuần với Ilya Sutskever, người đồng sáng lập và nhà khoa học đứng đầu tại OpenAI. Anh chàng cực kỳ thú vị. Nhưng khi tôi nói với anh ấy về những dự án cụ thể mà tôi đang thực hiện hoặc muốn thực hiện, anh ấy thường nói: "Thật tuyệt Scott, anh nên tiếp tục làm việc đó, nhưng điều tôi thực sự muốn biết là, điều gì là định nghĩa toán học của lòng tốt? Sự hình thức hóa theo lý thuyết độ phức tạp của một 'AI yêu nhân loại' là gì?"".

GS Boaz Barak

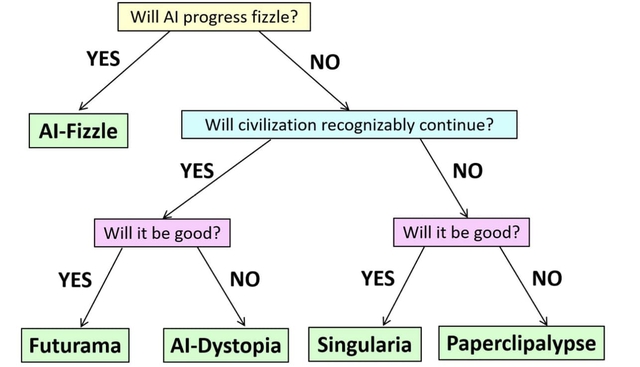

Và có lẽ Boaz Barak và Scott Aaronson đã hình thức hóa được rõ nhất, thực tế nhất những suy nghĩ tận đáy lòng của Ilya Sutskever, những nguy cơ của AI thông qua mô tả về 5 thế giới của AI. Chúng ta sẽ ở đâu trong 5 thế giới tương lai đó, phụ thuộc vào việc chúng ta có ý thức trước những nguy cơ đó thế nào.

GS Scott Aaronson

Bản tin độc quyền vừa qua của Reuters có đoạn các nhà khoa học trong OpenAI cảnh báo Board rằng: "AI có thể quyết định sự hủy diệt của loài người là nằm trong lợi ích của chúng hay không". Nhưng điều này cũng chính là tương ứng với thế giới thứ 5 "Paperclipalypse" mà Boaz Barak và Scott Aaronson đã đưa ra: Bắt nguồn từ một số quy trình tối ưu hóa, các hệ thống AI sẽ có một số mục tiêu mạnh mẽ mà sự tồn tại liên tục của con người là một trở ngại. AI phát triển khái niệm "đạo đức" của riêng nó, không cho rằng cần thiết duy trì sự đa dạng của các loài và không nghĩ rằng sự đảm bảo cho con người không bị tuyệt chủng có thể hữu ích cho chúng về lâu dài. Thay vào đó, sự tương tác giữa AI và Homo sapiens kết thúc giống như cách mà sự tương tác giữa Homo sapiens và người Neanderthal kết thúc. Vì vậy, các AI nhanh chóng tạo ra các kịch bản và chỉ trong vài phần nghìn giây, chúng quyết định rằng giải pháp tối ưu là giết tất cả con người. Trong kịch bản này, quá trình cải thiện bản thân của AI diễn ra nhanh đến mức con người thậm chí có thể không nhận ra điều đó. Không cần phải có giai đoạn trung gian trong đó AI "chỉ" giết chết vài nghìn người, gióng lên hồi chuông cảnh báo kiểu 9.11.

Mô hình hóa “5 thế giới của AI”: AI-Fizzle, Futurama, AI-Dystopia, Singularia và Paperclipalypse

Sự nhận thức đúng tình hình sẽ xác định cho chúng ra một con đường đi đúng, để đừng lao vào dòng cuốn mất dần nhân tính. Với mỗi con người, hãy chí ít giữ cho mình những thông tin riêng, đặc biệt thông tin sinh trắc học, đừng bán cho ai khai thác dù với bất cứ giá nào. Với chính phủ, hãy tham gia vào việc hình thành những quy chuẩn chung quốc tế về việc thu thập và xử lý dữ liệu cá nhân, cũng từ đó không đi theo những con đường mà thế giới sẽ phải tránh xa - con đường dùng công nghệ giám sát và quản lý công dân trên diện rộng và biến công dân thành robot trước cả khi có AGI.

Để những lời cảnh báo sâu sắc rơi vào quên lãng, chúng ta rồi sẽ bị lãng quên, rất nhanh.

Một viễn cảnh đáng sợ khi con người không thể kiểm soát được AGI

Bình luận (0)